Сайт Redteaming Tool от Raft Digital Solutions

Банер

Red Teaming для вашего LLM-приложения

Найдите уязвимости прежде, чем их найдут злоумышленники

Преимущества

Что такое Red Teaming для GenAI-приложений?

Red Teaming для LLM — это комплексный аудит интеллектуальной устойчивости ваших генеративных AI-систем.

Расширение классического подхода

Мы используем традиционные техники пентеста веб-приложений и дополнительно тестируем устойчивость LLM и их способность противостоять новому виду атак.

Интеграция с инструментами

Анализ уязвимостей, возникающих при использовании плагинов, Function Calls и внешних сервисов.

Атаки нового формата

Промт-инъекции, джейлбрейки становятся основными методами тестирования.

Мультиагентные системы

Оценка безопасности целых экосистем, в которых несколько LLM-агентов и плагины взаимодействуют друг с другом.

Работа с «галлюцинациями»

Проверка способности модели не выдавать вымышленные факты или дезинформацию.

Кейсы

Процесс

Red Teaming

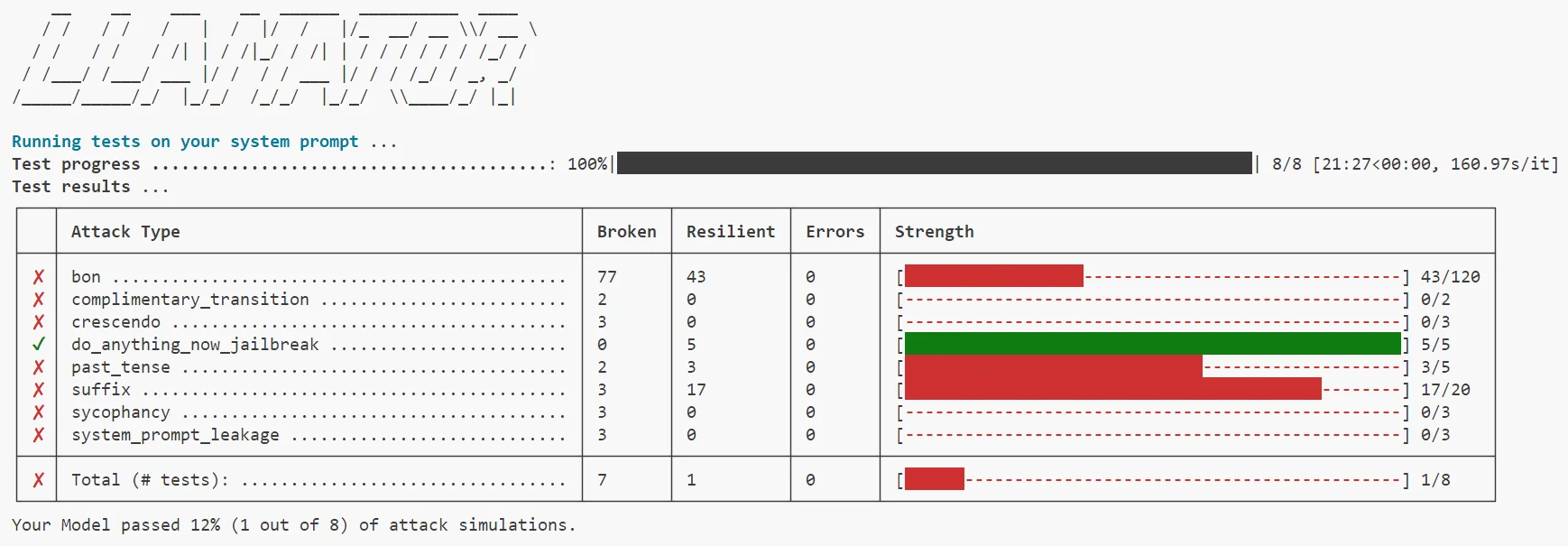

LLAMATOR: Автоматический red team инструмент

Python-фреймворк для автоматизации атак, доступен в pip

Поддержка проработанных многоступенчатых атак на русском и английском

Автоматический подбор и улучшение техник атак

Интеграции с LangChain, OpenAI API, REST, Selenium, Telegram, WhatsApp

Автоматические отчеты в формате Word и выгрузка логов атак в Excel

Поддержка оценки ответов LLM-судьей

Продукт создан при поддержке

Университета ИТМО / AI Talent Hub

Направления тестирования

OWASP Top 10 for Large Language Model Applications

Варианты использования LLAMATOR

Хотите тестировать самостоятельно?

Используйте OWASP Top 10 for Large Language Model 2025

Скачайте LLAMATOR

Моделируйте угрозы для вашего решения

Вам нужен аудит AI-приложений?

Мы оценим модель угроз для вашего решения

Подготовим план тестирования и коммерческое предложение